Et si vous ne pouviez pas entendre le monde qui vous entoure ?

Imaginez devoir commander un café, passer un entretien ou regarder une vidéo sans sous-titres… pour des millions de personnes sourdes ou malentendantes, c’est une réalité quotidienne.

Selon l’Organisation Mondiale de la Santé (OMS), près de 466 millions de personnes dans le monde vivent avec une surdité ou une malentendance, soit 1 personne sur 20.

Pourtant, leurs besoins sont souvent oubliés dans la conception des outils numériques, accentuant l’isolement social et l’inégalité d’accès à l’information envers les personnes souffrant de ce type de handicap.

Absence d’interprètes, faible accessibilité au contenu audiovisuel, exclusion dans les environnements éducatifs ou professionnels… les obstacles sont nombreux.

Et bien que la langue des signes soit leur principal mode de communication, elle est encore rarement intégrée aux technologies du quotidien.

C’est pour répondre à ce manque que nous avons développé Hands Up, une application mobile interactive alimentée par des algorithmes d’intelligence artificielle, capable de traduire la langue des signes en texte en temps réel.

Notre objectif ? Faciliter la communication entre les signants et les non-signants et contribuer à une société plus inclusive.

Mais développer une telle technologie pose de nombreux défis. La langue des signes possède une grammaire propre, très différente de celle des langues orales, et varie selon les pays, voire selon les régions.

À cela s’ajoute un manque cruel de données : les jeux de données existants sont rares, peu diversifiés et souvent limités à une seule langue, ce qui empêche les modèles d’IA de généraliser et de s’adapter aux différentes communautés linguistiques.

Conscient de ces limites, nous avons adopté une approche méthodique, en nous concentrant dans un premier temps sur la langue allemande avec le dataset de référence Phoenix-2014-T et en optimisant les performances de notre modèle pour obtenir une solution robuste et fiable.

Dans cet article, nous vous emmenons dans les coulisses de Hands Up : découvrez comment l’intelligence artificielle peut transformer le quotidien des personnes sourdes ou malentendantes grâce à ses algorithmes et au fonctionnement de notre application.

Hands Up : quand la technologie se met au service de l’inclusion

Et si comprendre la langue des signes devenait aussi simple que filmer une vidéo ? C’est le pari de Hands Up, une application mobile conçue pour faciliter les échanges entre personnes sourdes ou malentendantes et non-signeurs. Grâce à une interface intuitive et à la puissance de l’intelligence artificielle, Hands Up rend la communication plus simple et surtout plus accessible !

Découvrez Hands Up en action !

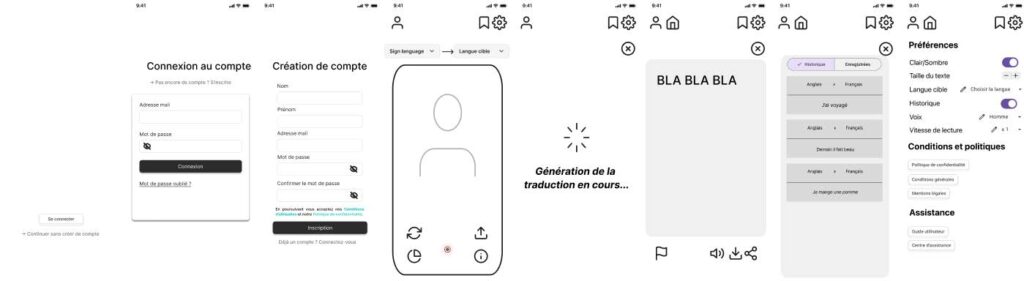

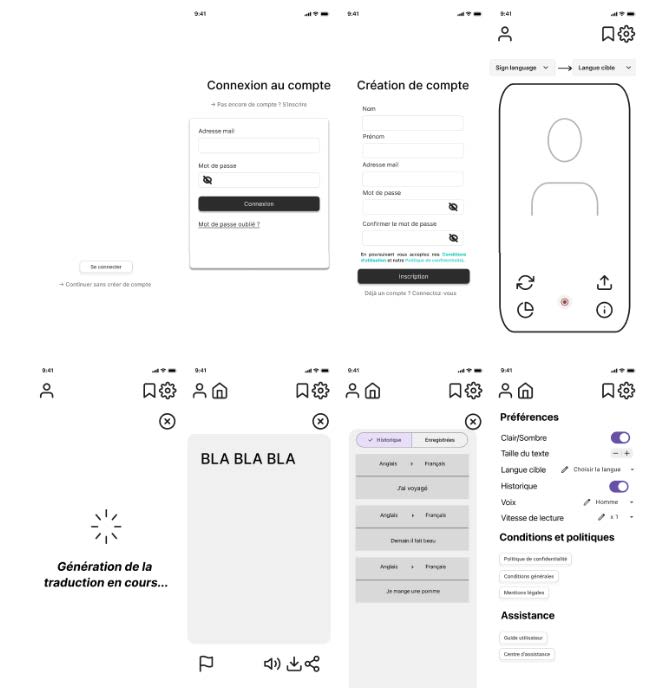

L’expérience commence par une interface simple et intuitive : l’utilisateur se connecte ou crée un compte en quelques clics. Pas besoin d’être un pro de la tech : si vous savez filmer, vous savez utiliser Hands Up !

Que ce soit pour enregistrer une personne en train de signer ou se filmer soi-même, l’application permet de basculer facilement entre la caméra frontale et la caméra arrière, selon la situation. À l’écran, une zone de cadrage en pointillés aide à bien positionner les mains et le corps pour une reconnaissance optimale des gestes.

Une fois la vidéo lancée, Hands Up analyse automatiquement la séquence grâce à l’intelligence artificielle. La langue des signes utilisée est détectée automatiquement, ou peut être sélectionnée manuellement via un menu déroulant. L’utilisateur choisit ensuite la langue cible souhaitée pour la traduction, puis lance l’enregistrement d’un simple clic.

Après quelques secondes, la traduction est générée. Le message peut alors être lu à l’écran, écouté via une lecture audio (voix masculine ou féminine au choix), téléchargé ou même partagé via d’autres applications ou plateformes. Il ne vous reste plus qu’à consulter la traduction… et poursuivre la discussion !

Derrière la simplicité, une IA puissante

Si tout semble si fluide côté utilisateur, c’est parce que Hands Up repose sur une architecture d’intelligence artificielle robuste.

Mais alors, comment fonctionne réellement cette technologie ? Quelles sont les briques techniques qui permettent à l’application de reconnaître, comprendre et traduire la langue des signes en temps réel ?

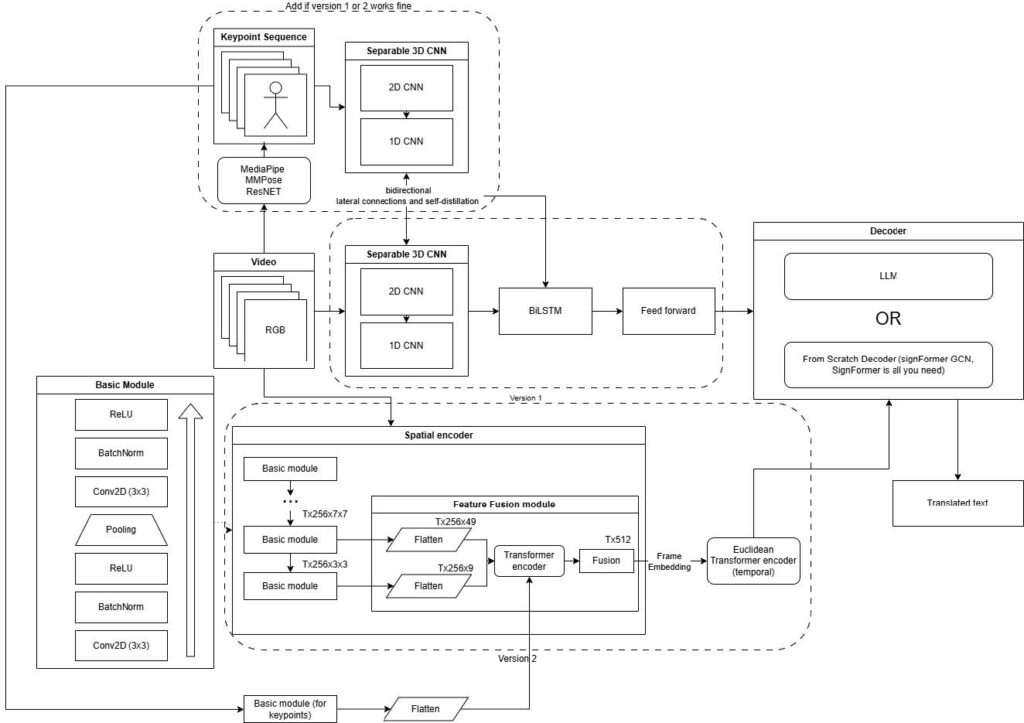

Derrière la simplicité d’utilisation de Hands Up se cache une architecture d’intelligence artificielle complexe. Voici comment chaque geste filmé devient un mot, puis une phrase en langage naturel compréhensible par tous.

Tout commence avec la vidéo enregistrée par l’application, où le signeur effectue les gestes. Cette séquence vidéo est d’abord segmentée en images RGB (images couleur), sur lesquelles deux types d’informations vont être extraites :

● Les caractéristiques visuelles (features RGB)

● Les points clés du corps, appelés keypoints, détectés grâce à MediaPipe

Ces keypoints, au total 127 points par image, correspondent à des coordonnées précises placées sur le corps du signeur pour reconstituer un modèle simplifié de son squelette.

Voici comment ils sont répartis :

● 33 points pour le corps, capturant la position des épaules, coudes, hanches ou genoux ;

● 42 points pour les mains, permettant de suivre les mouvements détaillés des doigts et des paumes, indispensables en langue des signes ;

● 52 points pour le visage, qui enregistrent les expressions faciales comme les mouvements des sourcils, des yeux ou de la bouche — des éléments clés pour nuancer le sens d’un signe.

Ces keypoints sont extraits par MediaPipe, une bibliothèque développée par Google spécialisée dans la détection de poses et de mouvements humains en temps réel.

MediaPipe peut détecter jusqu’à 468 points sur le visage, mais dans le cadre de Hands Up, cette quantité a volontairement été réduite à 52 points clés soigneusement sélectionnés. L’objectif est de préserver un bon équilibre entre les différentes parties du corps, notamment entre le visage et les mains, pour éviter que le modèle ne donne trop de poids à l’un au détriment de l’autre.

Cette réduction limite également le risque de surapprentissage, un phénomène où l’IA apprend des détails trop spécifiques sans réussir à généraliser. En se concentrant sur les zones les plus expressives et informatives du visage, Hands Up garantit une reconnaissance plus fiable, rapide et cohérente des signes.

Deux flux pour mieux comprendre :

Le modèle IA de Hands Up fonctionne avec deux types de données en parallèle, ce qui lui permet de mieux comprendre les gestes.

1. Premier flux : Les images RGB, redimensionnées en 224 x 224 pixels puis normalisées, sont analysées par un CNN 2D (ResNet18). Ce réseau extrait les caractéristiques spatiales utiles à la compréhension du geste, c’est-à-dire des éléments visuels importants comme la forme des mains, la position des doigts, ou la posture générale, qui aident à reconnaître le geste.

2. Deuxième flux : En parallèle, les keypoints (coordonnées 2D) suivent un autre chemin, mais avec une architecture similaire.

Pour analyser les mouvements dans le temps, la vidéo (ou la séquence de keypoints) est divisée en petites fenêtres superposées. Chaque fenêtre contient 8 images RGB (ou images keypoints), et on avance de 4 images à chaque nouvelle fenêtre, ce qui permet d’avoir un recouvrement. Cette technique aide le modèle à mieux capter la continuité et les variations des gestes.

Chaque fenêtre est ensuite passée à un CNN 1D, un réseau neuronal qui détecte les motifs locaux dans la séquence temporelle — par exemple, comment un geste commence et évolue sur quelques images.

Enfin, les résultats de ces CNN 1D sont envoyés dans un BiLSTM (Long Short-Term Memory bidirectionnel), un type de réseau qui comprend les relations complexes dans une séquence et peut regarder le passé et le futur pour mieux saisir la dynamique complète du mouvement.

Fusion des données pour une compréhension optimale

Après avoir traité séparément les deux flux, leurs représentations sont synchronisées puis fusionnées. À cette étape, un module de connexion latérale bidirectionnelle entre en jeu : chaque flux est projeté dans l’espace de l’autre, pour s’enrichir mutuellement. Puis, les deux versions améliorées sont à nouveau fusionnées pour générer un troisième flux combiné.

Ce sont ces trois flux complémentaires qui servent à la prédiction finale des gloses — des unités lexicales en langue des signes, équivalentes à des mots.

Des glose à la phrase : l’apport du langage naturel

Mais l’aventure ne s’arrête pas là. Une suite de gloses comme « MOI MANGER POMME » ne forme pas encore une phrase française naturelle, c’est pourquoi Hands Up fait appel à T5-base, un modèle de langage pré-entraîné développé par Google. Ce puissant réseau de neurones, entraîné sur d’immenses corpus de textes, maîtrise la grammaire, la syntaxe et le contexte, lui permettant de transformer la séquence brute de gloses en une phrase claire, fluide et grammaticalement correcte, fidèle au sens original.

Ainsi, la séquence “MOI MANGER POMME” devient “Je mange une pomme” — une traduction fluide qui respecte à la fois la signification et la structure propre à la langue française, rendant la communication plus naturelle et accessible.

Hands Up, c’est donc bien plus qu’une application de reconnaissance gestuelle. C’est un concentré d’IA visuelle, de traitement du langage naturel et de vision par ordinateur, mis au service de l’inclusion et de l’accessibilité.

Une technologie qui redonne la parole

En conclusion, et si l’innovation ne se résumait pas à la performance, mais à l’inclusion ? Hands Up n’est pas seulement une application : c’est une avancée majeure vers une société plus accessible, où chacun peut communiquer, apprendre et s’exprimer librement, peu importe ses capacités.

En traduisant la langue des signes en temps réel, cette technologie redéfinit les interactions entre les communautés, tout en mettant en lumière le potentiel de l’intelligence artificielle au service du lien humain.

Les défis sont encore nombreux, mais Hands Up remet la communication à portée de main.

Ensemble, brisons les barrières du silence !