Découvrez comment l’Intelligence Artificielle (IA) peut transformer la vie des personnes atteintes de déficiences visuelles en leur offrant plus de liberté et d’autonomie au quotidien. Cet article explique les différents aspects du quotidien des personnes ayant un handicap visuel, et des solutions basées sur l’Intelligence Artificielle pour répondre à ces défis.

Apprenez-en plus sur notre nouvelle solution, “Find Your Way”, conçue pour offrir une assistance autonome aux personnes aveugles et malvoyantes, sans nécessiter d’intervention humaine directe.

En France, près de 1,7 million de personnes sont atteintes d’un trouble de la vision après des corrections ou traitements nécessaires. La gravité se décline selon l’atteinte de la perte de vision. Ainsi, 207 000 personnes sont considérées comme aveugles, c’est-à-dire sans perception de la lumière, ou malvoyants profonds, ayant une vision résiduelle limitée à la distinction de silhouettes. À ces personnes s’ajoutent 932 000 personnes souffrant de malvoyance moyenne, pour qui la vision de loin est si sévèrement altérée qu’elles ne peuvent distinguer un visage à 4 mètres, après correction du meilleur œil.

Cécité Malvoyance profonde

De plus, l’Organisation Mondiale de la Santé (OMS) prévoit de compter jusqu’à deux fois plus de personnes malvoyantes d’ici 2050, en raison du vieillissement de la population. En effet, 81% des personnes atteintes de troubles de la vision sont âgées de 50 ans et plus, lorsqu’apparaissent généralement les premiers symptômes de la DMLA (Dégénérescence Maculaire Liée à l’Age). Les principales causes de déficience visuelle chez les seniors incluent les troubles de la vision non corrigés, la cataracte, le glaucome, ou encore la DMLA, cette dernière étant la principale cause de cécité chez les personnes âgées en Occident.

Malgré ces chiffres, le manque d’outils d’assistance adaptés reste un défi majeur pour les personnes aveugles et malvoyantes. En effet, les solutions qui leurs sont proposées sont souvent insuffisantes (cane blanche), ou nécessitent une aide extérieure (humaine ou chien guide). Cela ne peut pas leur offrir l’autonomie que Find Your Way leur propose.

L’Intelligence Artificielle est aujourd’hui intégrée dans presque tous les aspects de notre quotidien, ainsi notre solution met ces technologies au service de l’indépendance des personnes atteintes de déficience visuelle.

Comment Find Your Way détecte l’environnement pour guider les utilisateurs et éviter les obstacles sur leur route ?

Se déplacer dans un environnement inconnu de manière autonome est une épreuve pour les personnes aveugles ou malvoyantes. Find Your Way est une application capable de transformer une simple vidéo de l’environnement en une carte permettant de se guider dans celle-ci. Plongeons dans les technologies cachées derrière ce processus pour comprendre comment cette innovation fonctionne.

Find Your Way permet de cartographier une pièce afin de proposer à l’utilisateur un guidage optimal. Elle rassemble donc ces deux caractéristiques :

Passer d’une vidéo à une carte en 3D par le biais de la technologie SLAM

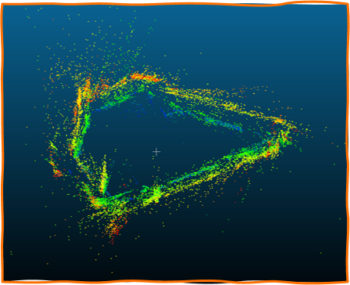

Le processus de SLAM (Simultaneous Localization And Mapping) vise à cartographier un environnement inconnu et à localiser simultanément un système de capteurs dans cet environnement grâce aux signaux fournis par le(s) capteur(s). Nous avons travaillé sur ORBSLAM3, qui construit une carte 3D de l’environnement afin de faire de la recherche de chemin pour guider l’utilisateur, tout en suivant la position de celui-ci en temps réel.

Comment cela fonctionne-t-il ?

Premièrement, l’utilisateur filme son environnement avec la caméra de son smartphone. Cela constitue la capture vidéo de l’environnement. A partir de celle-ci, SLAM stocke la première image d’entrée reçue et extrait des points d’intérêt visuels (caractéristiques) de celle-ci. Ensuite, le suivi consiste à faire correspondre ces caractéristiques afin d’identifier toute image similaire à la première, et ainsi de suite pour chaque image de la vidéo. En suivant ces points d’intérêt à travers les images, SLAM construit une carte tridimensionnelle de l’environnement. Puis, un processus de cartographie locale ajoute de nouveaux points 3D à la carte (ajustement de faisceau, profondeur, inertie, …). Lorsque l’algorithme retombe sur la première image d’entrée, une boucle est détectée et la carte est affinée.

SLAM offre plusieurs avantages pour l’utilisation de Find Your Way. Premièrement, en continu, la position de l’utilisateur est estimée par rapport à la carte créée, permettant un guidage précis. De plus, les utilisateurs peuvent se déplacer de manière autonome dans des environnements auparavant inconnus ou complexes. En modélisant l’environnement, le SLAM aide les utilisateurs à comprendre leur position relative et à s’orienter facilement. Cela développe leur indépendance, en pouvant se passer d’une cane ou d’un chien guide. Un autre point positif de SLAM est son adaptabilité, car il peut être utilisé dans divers environnements. Cette flexibilité permet aux utilisateurs de s’adapter à différents contextes de déplacement.

Cette technologie permet donc à l’application de comprendre où se trouve l’utilisateur et de modéliser l’environnement qui l’entoure. Voici un exemple de mapping (création d’une carte 3D par SLAM) d’un couloir, sous forme d’un nuage de points.

Faciliter le déplacement au sein de la carte en détectant les potentiels obstacles

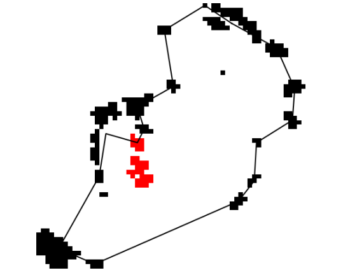

Un nuage de points à lui seul ne fournit pas beaucoup d’informations. Pour aller au-delà, nous avons utilisé YOLOv5, une version de la famille de modèles (YOLO – You Only Look Once), réputée pour sa rapidité et sa précision. YOLOv5 a été adapté pour détecter des objets pertinents comme les tables à manger, chaises, canapés, personnes, bancs, lits et réfrigérateurs. En effet, Find Your Way veut avant tout détecter des environnements intérieurs, pour offrir aux utilisateurs une indépendance dans les milieux qu’ils côtoient le plus.

Comment YOLO peut-il détecter les obstacles ?

Tour d’abord, la vidéo capturée par la caméra est analysée en temps réel par l’algorithme YOLO. YOLO identifie et localise différents objets dans chaque image, tels que des tables, chaises ou tout autres obstacles potentiels. Cela permet de signaler ces obstacles, car les informations sur les objets détectés sont transmises analysées pour pouvoir les éviter plus tard lors de déplacements. Dans l’image ci-dessous, on peut observer la trajectoire que l’on peut suivre, en évitant les obstacles. Ici, les points rouges correspondent à des chaises reconnues par YOLO. La détection précise de ces objets renforce la robustesse de notre outil de navigation.

L’intégration de ORBSLAM 3 et YOLO dans Find Your Way offre de grands avantages aux utilisateurs, car le déplacement est une réelle épreuve dans la vie quotidienne des personnes aveugles ou malvoyantes. En utilisant ORBSLAM3 pour la cartographie et YOLOv5 pour la détection d’objets, nous permettons donc aux utilisateurs de se déplacer de manière plus indépendante et confiante. Ainsi, les utilisateurs peuvent se déplacer en toute confiance sans dépendre de l’assistance humaine ou animale.

Comment l’Intelligence artificielle peut répondre aux questions sur l’environnement ?

Vous l’aurez compris, l’Intelligence Artificielle est omniprésente dans les nouvelles technologies. Elle est capable de guider les personnes aveugles et malvoyantes, mais ce n’est pas sa seule fonctionnalité ! En effet, dans les dispositifs pour personne aveugle / malvoyante, l’Intelligence Artificielle est utilisée pour répondre à des questions sur l’environnement. Plus précisément, elle possède deux principes : la VQA (Visual Question Answering) et l’OCR (Optical Character Recognizion). Mais en quoi cela consiste ?

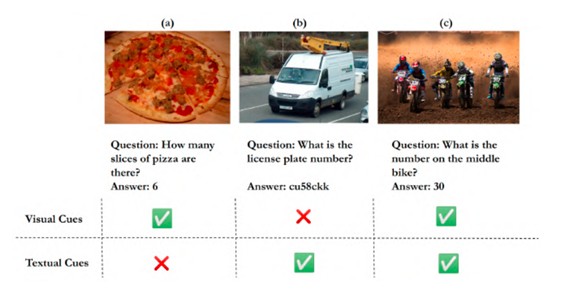

La VQA, ou Réponse aux Questions Visuelles, est une technologie qui permet de répondre à des questions posées sur des images ou des vidéos en utilisant les informations visuelles contenues dans ces médias. L’OCR, quant à lui, fait le même travail mais dirigé sur du texte et est donc capable de lire des panneaux, des affiches etc.

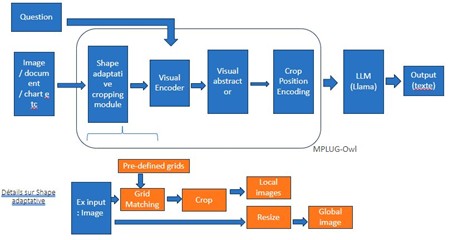

Voici un schéma du processus de réponse aux questions visuelles dans notre application mobile Find Your Way :

Quel est le processus derrière la VQA et l’OCR ?

La VQA et l’OCR, peuvent fonctionner ensemble dans un même algorithme ou alors séparément. Dans l’application Find Your Way par exemple, le VQA et l’OCR fonctionnent ensemble, ce qui permet une réponse optimale et plus rapide. En général, l’algorithme est implémenté sous forme de code Python et nécessite deux entrées pour son fonctionnement : une image et une question. Voici le fonctionnement des deux modules séparément :

Visual Question Answering (VQA)

Tout d’abord, l’image est passée à travers un réseau de neurones convolutif (CNN) pré-entraîné, tel que ResNet, pour extraire des caractéristiques visuelles importantes. Ces caractéristiques permettent de capturer des informations comme la forme, la couleur et la texture des objets dans l’image. Simultanément, la question posée est analysée en utilisant des techniques de traitement du langage naturel (NLP). Cette étape transforme le texte en une représentation numérique qui peut être interprétée par l’algorithme. Les représentations des caractéristiques visuelles et de la question sont ensuite fusionnées. Cela peut être réalisé en concaténant les vecteurs de caractéristiques ou en utilisant des réseaux de neurones multimodaux qui apprennent à combiner les deux types d’informations de manière optimale. Enfin, un réseau de neurones dense (fully connected) ou une couche de sortie softmax est utilisé pour prédire la réponse à la question posée sur l’image, basée sur la combinaison des informations visuelles et textuelles.

La technologie sur laquelle s’appuie l’application Find Your Way pour exercer de la VQA et de l’OCR s’appelle Mplug-Owl. Cet algorithme permet de traiter l’image et la question de deux manières différentes avant de les assembler dans ce qu’on appelle un visual encoder. Ce dernier va permettre d’assembler les mots de la question (contenus dans ce qu’on appelle des vecteurs) avec les caractéristiques visuelles de l’image. Cet assemblage sera ensuite décodé et permettra de répondre de manière précise à la question posée.

Ci-dessous, un tableau avec images et leur réponse associée :

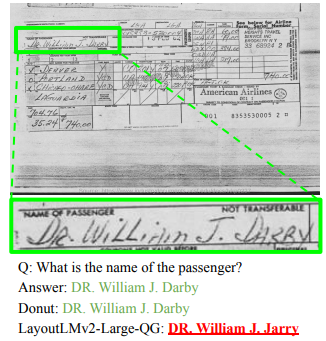

Optical Character Recognition (OCR)

L’image contenant le texte est d’abord prétraitée pour en améliorer la qualité, par exemple en ajustant le contraste ou en réduisant le bruit. Un détecteur d’objets, souvent basé sur un CNN, identifie les zones de l’image où se trouve du texte potentiellement lisible. Pour chaque zone détectée, un algorithme analyse la disposition des caractères et utilise des techniques comme la séparation par lignes ou par mots pour isoler chaque caractère individuel. Chaque caractère isolé est ensuite comparé à une base de données de formes de caractères connues. Des techniques avancées telles que les réseaux de neurones récurrents (RNN) ou les Transformers sont souvent utilisées pour interpréter chaque caractère et corriger les erreurs potentielles. Enfin, un processus de post-traitement peut être appliqué pour améliorer la précision globale en considérant le contexte et en corrigeant les erreurs de reconnaissance.

L’OCR-VQA est donc un très bon moyen pour avoir des réponses de qualité et qui s’adapte à l’environnement. La plupart des modèles utilisés sont rapides et permettent ainsi une réponse pratiquement instantanée.

Comment le smartphone devient le meilleur allié pour développer l’autonomie des aveugles ?

Dans le monde d’aujourd’hui, la technologie joue un rôle crucial dans l’amélioration de la qualité de vie des personnes aveugles. Parmi tous les outils disponibles, le smartphone se distingue comme un support exceptionnel, offrant une panoplie de fonctionnalités adaptable pour répondre aux besoins des utilisateurs malvoyants, tout en leur garantissant une certaine discrétion.

Une application simplifiée pour une accessibilité optimale

L’avantage de l’utilisation d’un smartphone par des personnes aveugles est une application mobile simplifiée et développée chez Aubay Innov : Find Your Way !

Intégrant deux interfaces distinctes (une pour les personnes aveugles et l’autres pour les personnes malvoyantes modérées) pour une meilleure expérience utilisateur, cette conception intuitive permet aux utilisateurs de naviguer facilement et efficacement dans leur quotidien.

Des fonctionnalités sur mesure pour une expérience optimisée

Grâce à des fonctionnalités telles que le chat vocal, les cartes interactives adaptées aux malvoyants et la commande vocale, le smartphone devient bien plus qu’un simple outil de communication. Il devient un véritable guide personnel, offrant une grande autonomie et une connectivité sans précédent.

Avantages clairs pour une utilisation quotidienne

L’utilisation du smartphone présente de nombreux avantages tel que :

- La praticité : Etant un objet du quotidien peu encombrant, le smartphone devient un compagnon fiable et accessible à tout moment.

- L’adaptabilité : Find You Way est une application spécialement conçue pour les besoins des utilisateurs malvoyants et aveugles garantissent une expérience utilisateur fluide et adaptée.

- Facilité d’utilisation : C’est une application facile à télécharger et à lancer, le smartphone offre une ergonomie sans égal, répondant aux besoins de chacun en toute simplicité.

Le smartphone représente bien plus qu’un simple appareil électronique : c’est un outil révolutionnaire qui transforme la vie des personnes présentant une déficience visuelle en leur offrant une meilleure indépendance et une connectivité sans limite.

Si vous cherchez à optimiser votre autonomie ou celle de vos proches, le smartphone se présente comme le choix idéal pour une vie plus connectée et épanouie.

Conclusion

En conclusion, l’Intelligence Artificielle (IA) est devenue un outil indispensable pour l’assistance des personnes malvoyantes et aveugles. Grâce à ses diverses applications, elle offre des solutions innovantes telles que le guidage, la détection d’obstacles et l’interprétation de l’environnement. Ces avancées technologiques permettent aux personnes ayant des déficiences visuelles de gagner en autonomie et en qualité de vie, en leur fournissant un soutien adapté à leurs besoins quotidiens. L’IA est notamment adaptable pour les smartphones sous forme d’application mobile, facilitant ainsi son utilisation dans la vie de tous les jours. L’évolution continue de l’IA promet de nouvelles améliorations et opportunités pour rendre notre société encore plus inclusive et accessible à tous.