Dans un monde où l’intelligence artificielle (IA) devient omniprésente, de la médecine à la finance en passant par le commerce électronique, il est crucial de comprendre non seulement ce que ces systèmes font, mais aussi comment ils prennent leurs décisions. Cette nécessité d’interprétation a donné naissance à un domaine crucial de l’IA moderne : l’explicabilité de l’intelligence artificielle, ou XAI (eXplainable Artificial Intelligence). L’XAI vise à rendre les processus internes des modèles d’IA transparents, compréhensibles et interprétables pour les humains.

L’objectif de l’explicabilité est de démystifier les “boîtes noires” que sont souvent les modèles d’IA complexes. Ces modèles, bien qu’efficaces et précis, prennent des décisions basées sur des milliers, voire des millions de paramètres, rendant leurs processus de décision internes opaques. L’XAI permet de décoder ces processus, offrant ainsi aux utilisateurs, aux développeurs et aux régulateurs des explications claires et compréhensibles. Cela est essentiel non seulement pour instaurer la confiance, mais aussi pour garantir l’équité, la responsabilité et la conformité aux réglementations.

C’est pourquoi nous nous sommes penchés sur ce sujet. Nous avons exploré la méthode traditionnelle d’utilisation de l’XAI pour expliquer les résultats d’un modèle, mais nous avons également trouvé une manière innovante d’utiliser l’XAI : améliorer les performances d’un modèle de génération d’images en intégrant des méthodes d’XAI directement dans celui-ci.

Dans cet article nous parlerons des GNNs avec GNNExplainer et SubGraphX et des GANs avec SPADE et Saliency Maps.

1. Expliquer des modèles d’IA : utiliser l’XAI pour décrypter les prédictions

Les Graph Neural Network (GNN), Réseaux de Neurones Graphiques en français, sont une classe particulière de réseaux de neurones adaptés au traitement de données structurées sous forme de graphes.

Contrairement aux réseaux de neurones classiques, qui sont souvent utilisés pour analyser des données tabulaires ou séquentielles, les GNN sont conçus pour modéliser les relations et les interactions entre les différentes entités d’un graphe, qu’il soit orienté ou non.

Les GNN sont donc des outils puissants pour des applications telles que la prédiction de l’humidité et de la sécheresse.

Dans ce contexte, deux modèles spatio-temporels basés sur GNN ont été utilisés pour expliquer les prédictions faites.

a. Modèle 1 : Prédiction de l’Humidité

Ce modèle utilise un réseau de neurones graphiques pour prédire les niveaux d’humidité du sol en se basant sur des données climatiques et environnementales (température moyenne, temps total des précipitations, densité de la végétation, humidité relative sur une journée, …) recueillies sur une période donnée dans les régions du Mississippi et de l’Alabama aux Etats-Unis.

Carte des stations météorologique en Alabama et Mississippi avec la prédiction de l’humidité (très humide en rouge)

b. Modèle 2 : Prédiction de la Sécheresse

De manière similaire, un autre GNN spatio-temporel a été utilisé pour prédire les épisodes de sécheresse, cette fois-ci dans la région du Henan en Chine.

Ce modèle prend en compte non seulement les données historiques des précipitations, de la température et de l’humidité du sol, mais aussi les interactions complexes entre différentes régions géographiques. En modélisant ces interactions, le GNN peut identifier les zones à risque de sécheresse.

Carte des stations météorologique en Chine dans la région du Henan montrant la prédiction de la sécheresse (très sec en rouge)

c. Explication des Modèles avec GNNExplainer et SubgraphX

Pour comprendre et interpréter les décisions de ces modèles complexes, deux techniques d’explicabilité spécifiques aux GNN ont été utilisées : GNNExplainer et SubgraphX.

GNNExplainer et SubgraphX

GNNExplainer est une méthode qui fournit des explications locales en identifiant les sous-graphes et les caractéristiques de nœuds les plus influents pour une prédiction donnée.

SubgraphX est une méthode plus avancée qui utilise des techniques d’exploration de sous-graphes pour fournir des explications globales et locales des modèles GNN. Contrairement à GNNExplainer, qui se concentre sur des explications locales, SubgraphX peut identifier des motifs plus larges et récurrents dans les données.

Voici comment ils ont été utilisés pour nos modèles :

– Prédiction de l’Humidité :

Chaque nœud du graphe représente une station météorologique, et les arêtes représentent les relations géographiques et météorologiques entre ces stations.

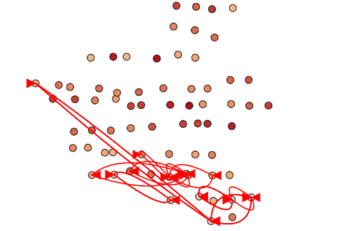

GNNExplainer a identifié les liens entre les différentes stations et les liens qui ont le plus d’importance sur la prédiction.

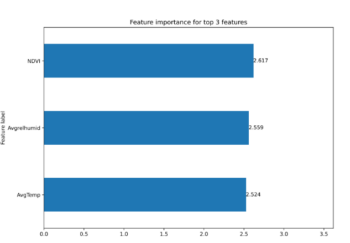

Sous graphe et top des 3 caractéristiques les plus importantes obtenus avec GNNExplainer pour la prédiction de l’humidité

Sur cet exemple, 3 caractéristiques ont été mises en avant pour la prédiction de l’humidité d’une station choisie à une date donnée : l’indice NDVI correspondant à la santé et la densité de la végétation l’humidité relative sur une journée et la température moyenne sur une journée.

– Prédiction de la Sécheresse :

Pour la sécheresse, GNNExplainer et SubgraphX ont révélé les régions géographiques et les périodes spécifiques où les conditions météorologiques interagissaient de manière à indiquer un risque accru de sécheresse. Cela a permis de mieux comprendre comment certaines conditions météorologiques locales et leurs interactions pouvaient conduire à des sécheresses prolongées.

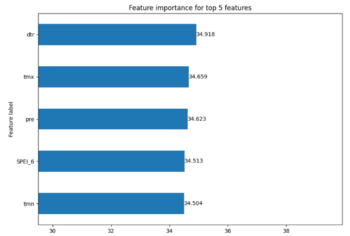

Sous graphe et top des 5 caractéristiques les plus importantes obtenus avec GNNExplainer pour la prédiction de la sécheresse

Ici GNNExplainer a permis d’extraire les 5 caractéristiques les plus influentes dans les résultats des prédictions :

- L’amplitude thermique journalière (température maximale – température minimale)

- La moyenne des températures maximales quotidiennes sur un mois donné,

- Le total des précipitations mesuré en mm

- L’indice de précipitation et d’évapotranspiration standardisé sur 6 mois (permet de classer la sécheresse selon 5 catégories)

- La moyenne des températures minimales enregistrées au cours d’une journée sur un mois

2. Améliorer les performances des modèles d’IA : intégration innovante des méthodes XAI

Un Generative Adversarial Networks (GAN) est un type de modèle d’intelligence artificielle composé de deux réseaux de neurones qui s’affrontent dans un jeu à somme nulle, où l’un essaie de tromper l’autre. Le GAN se compose de deux parties principales : le générateur et le discriminateur.

schema du modéle GAN. Source: Machine Learning Aided Design and Optimization of Thermal Metamaterials | Chemical Reviews (acs.org)

- Le générateur append à produire des données de plus en plus réalistes à partir de bruits aléatoires pour tromper le discriminateur

- Le discriminateur apprend à mieux distinguer les données réelles des données générées ce qui rend ainsi les exemples générés plus réalistes.

Les GANs sont utilisés dans divers applications, notamment la génération d’images réalistes, l’amélioration de la qualité d’image, la synthèse de données de formations pour des modèles lorsqu’il y a une pénurie de données réelles et la transformation de style.

XAI-GAN

Au cours de nos recherches, nous avons découvert un article décrivant un GAN amélioré grâce à l’intégration de méthodes d’XAI.

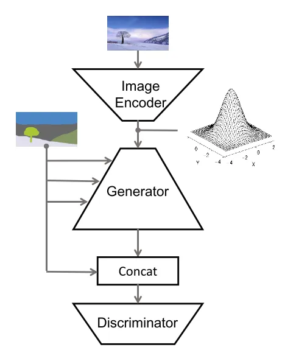

Schéma du modéle XAI-GAN. Source: xAI-GAN: Enhancing Generative Adversarial Networks via Explainable AI Systems | Logic + Machine Learning (ml-logic-seminar.github.io)

Le modèle XAI-GAN, ou “Explainable AI – Generative Adversarial Network,” combine la génération d’images avec des explications compréhensibles sur le fonctionnement du modèle. Contrairement aux GANs traditionnels, souvent considérés comme des boîtes noires, l’XAI-GAN intègre des techniques d’intelligence artificielle explicable pour rendre ses décisions transparentes et interprétables.

- Le discriminateur ne se contente pas de juger le réalisme des images, il fournit des commentaires détaillés sur ce qui ne va pas comme des bords flous ou des couleurs incorrectes.

- Le générateur utilise ces retours pour affiner ses créations améliorant ainsi la qualité des images de manière plus efficace.

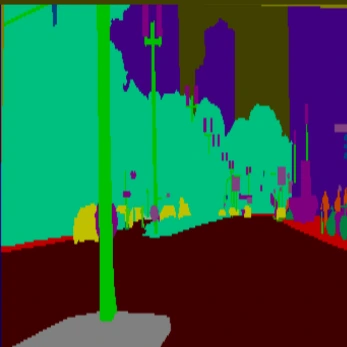

SPADE

Après avoir exploré comment les méthodes d’XAI peuvent améliorer les GANs, nous nous sommes tournés vers SPADE, une approche avancée qui pousse encore plus loin les capacités des GANs en termes de génération d’images réalistes et de contrôle sémantique.

Schéma du model SPADE de NVidia. Source: [PDF] Semantic Image Synthesis With Spatially-Adaptive Normalization | Semantic Scholar

Spatially-Adaptive Normalization (SPADE) est une technique avancée innovante utilisée dans le domaine de l’intelligence artificielle, notamment la génération d’images. Elle est particulièrement efficace dans les modèles GANs. L’idée de base de SPADE est d’améliorer la qualité des images générées en utilisant des informations spécifiques à chaque partie de l’image. En d’autres termes, SPADE ajuste les détails de l’image en fonction des caractéristiques de différentes zones de cette image. Par exemple, si une partie de l’image est censée représenter le ciel et une autre partie un bâtiment, SPADE aide le modèle à traiter ces zones de manière adaptée pour qu’elles aient l’air plus réalistes.

- Normaliser / uniformiser les données pour que les valeurs des pixels soient comparables.

- Ajuster cette normalisation en fonction de la carte sémantique de l’image. Une carte sémantique est une version simplifiée de l’image où chaque pixel est marqué pour indiquer quel type d’objet il représente comme le ciel ou un arbre.

- En utilisant les informations de l’étape 2, modifier la manière dont les détails sont ajoutés à l’image en s’assurant que chaque partie de l’image est traitée de manière appropriée pour son contexte spécifique.

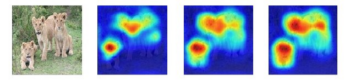

a. Saliency Maps

Tout au long de notre projet, nous avons utilisé une méthode d’XAI en particulier qui se nomme Saliency Maps.

Les saliency maps, ou cartes de saillance, sont des représentations visuelles qui mettent en évidence les parties d’une image ou d’une entrée auxquelles un modèle de réseau de neurones prête le plus d’attention. Elles sont générées en attribuant une importance à chaque pixel d’une image en fonction de son influence sur la sortie du modèle. Les régions avec une valeur élevée dans la carte de saillance sont celles que le modèle considère comme les plus significatives pour sa prédiction.

Les saliency maps offrent de nombreux avantages :

- Interprétation et explication :

Elles aident à comprendre quelles parties d’une image influencent le plus les décisions du modèle. Par exemple, dans la classification d’images, une carte de saillance peut montrer quelles régions de l’image sont les plus importantes pour prédire une certaine classe.

- Détection d’objets et segmentation :

Dans les tâches de détection d’objets et de segmentation, les saliency maps peuvent mettre en évidence les régions de l’image où les objets d’intérêt sont présents, améliorant ainsi la précision de ces tâches.

- Modélisation de l’attention humaine :

Elles modélisent l’attention humaine en prédisant où une personne regarderait dans une image. Cette fonctionnalité est utile pour des applications telles que le marketing visuel et l’ergonomie des interfaces utilisateur.

- Débogage et amélioration des modèles :

Elles permettent de déboguer et d’améliorer les modèles en identifiant les problèmes potentiels, comme une attention indue aux caractéristiques non pertinentes. Cela permet d’ajuster les modèles pour qu’ils se concentrent sur les aspects pertinents des données.

b. A quoi sert tout ça ?

L’intégration de l’XAI dans un modèle GAN offre plusieurs avantages. Nous avons découvert qu’il est possible d’obtenir les mêmes résultats voire des meilleurs résultats tout en utilisant moins de ressources. En effet les retours faits par l’XAI lors de l’entrainement permettent de réduire le nombre d’itérations pour avoir le même résultat. Cette approche permet de rendre le processus plus efficace, améliorant ainsi les performances globales du modèle. De plus, nous remarquons également une amélioration de la qualité des résultats obtenus en comparant ceux avant l’intégration de l’XAI et ceux après. À long terme, cette méthode pourrait transformer l’application des GANs dans divers secteurs, rendant l’intelligence artificielle plus accessible et durable.

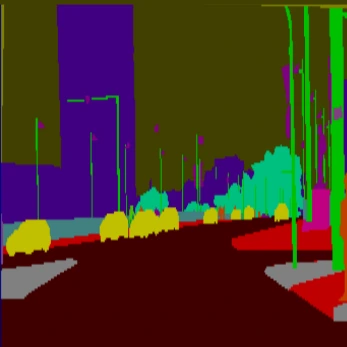

Nous avons appliqué ce modèle GAN amélioré avec de l’XAI à de la génération d’images à partir d’un dessin. Chaque couleur du dessin correspond à un élément différent comme le vert pour les arbres et le violet pour les bâtiments. Voici quelques exemples d’images générées avant et après amélioration du modèle.

Dans ces exemples, plusieurs améliorations notables peuvent être observées dans les images générées par notre modèle intégrant l’XAI par rapport aux images produites par le modèle de référence.

Les couleurs dans les nouvelles images sont significativement plus réalistes. Par exemple, nous passons d’un vert vif, qui semble artificiel, à un vert plus naturel et varié, qui ressemble beaucoup plus à de l’herbe réelle. Cette subtilité dans les nuances de vert contribue à une apparence générale beaucoup plus crédible.

Les textures ont également été améliorées. Dans les anciennes images, les surfaces peuvent apparaître plates et uniformes. En revanche, les nouvelles images montrent une complexité texturale accrue. Par exemple, l’herbe ne semble plus simplement verte mais présente des variations subtiles qui simulent la densité et les ombres que l’on pourrait observer dans un vrai champ.

Les formes dans les images après amélioration sont plus nettes et plus détaillées. Les contours des objets sont plus définis, réduisant l’effet flou souvent visible dans les images générées par des modèles non améliorés. Cette clarté permet une meilleure reconnaissance des objets par les utilisateurs, rendant les images non seulement plus esthétiques mais aussi plus fonctionnelles.

Enfin, les détails sont plus nombreux et mieux rendus. Par exemple, dans les scènes naturelles, on peut distinguer les différentes variétés de plantes et la finesse des feuilles, ce qui n’était pas aussi évident auparavant. Cette richesse de détails contribue à une immersion plus profonde et à une appréciation accrue des images générées.

| Entrée | Avant | Après |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Conclusion

L’intégration de techniques d’explicabilité comme GNNExplainer et SubgraphX dans les modèles de GNN spatio-temporels a permis de transformer ces “boîtes noires” en systèmes plus transparents et compréhensibles. Cela est particulièrement crucial pour les applications sensibles telles que la prédiction de l’humidité et de la sécheresse, où la compréhension des décisions du modèle peut conduire à des actions préventives et à une meilleure gestion des ressources.

En rendant les modèles d’IA explicables, nous pouvons non seulement améliorer leur performance et leur fiabilité, mais aussi renforcer la confiance des utilisateurs et des décideurs dans ces technologies avancées. L’explicabilité, en révélant les mécanismes internes des modèles, ouvre la voie à une utilisation plus responsable et éclairée de l’intelligence artificielle dans des domaines critiques pour notre société et notre environnement.

En recherche d’une opportunité de carrière dans les métiers de l’IA?

RDV dans notre espace carrière dédié 👉Espace Carrière